2016-2022 All Rights Reserved.平安财经网.复制必究 联系QQ 备案号:

本站除标明“本站原创”外所有信息均转载自互联网 版权归原作者所有。

邮箱:toplearningteam#gmail.com (请将#换成@)

在即将举行的2020年欧洲计算机视觉欧洲会议上接受的一项研究中,麻省理工学院和麻省理工学院的IBM Watson AI Lab研究人员描述了一种AI系统— Foley Music —可以从演奏乐器的音乐家的无声视频中产生“合理的”音乐。他们说,它可以在各种音乐表演中工作,并且在产生令人愉悦的音乐方面,其表现优于“几种”现有系统。

研究人员相信,可以从人体运动中推断出音乐的AI模型可以作为一系列应用程序的基础,从自动向视频添加声音效果到在虚拟现实中创建沉浸式体验。来自认知心理学的研究表明,人类具有这种技能,例如,甚至幼儿也报告说,他们听到的声音受到他们看到一个人说话后所收到的信号的影响。

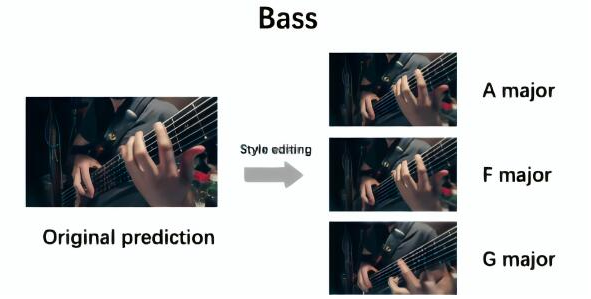

Foley Music从视频帧中提取人体的2D关键点(总共25个点)和手指(21个点)作为中间视觉表示,用于建模身体和手部动作。对于音乐,系统采用MIDI表示形式,对每个音符的时间和响度进行编码。给定关键点和MIDI事件(通常约有500个),“图形转换器”模块学习映射功能以将运动与音乐相关联,捕获长期关系以产生手风琴,低音,低音管,大提琴,吉他,钢琴,大号,四弦琴和小提琴夹。

系统不会将MIDI事件转换为音乐,但研究人员指出,可以将它们导入标准的合成器中。团队需要培训神经综合器,以自动执行此操作以用于将来的工作。

在实验中,研究人员在三个数据集上对Foley Music进行了训练,这些数据集包含属于11个类别的1,000个音乐表演视频:URMP,一种记录在工作室中的高质量多乐器视频语料库,为每个录制的视频提供MIDI文件;AtinPiano,这是一个YouTube频道,其中包含钢琴视频录制,并且相机俯视键盘和手;和MUSIC,一种未修剪的视频数据集,可通过从YouTube查询关键字来下载。

研究人员让受过训练的Foley Music系统生成了450个视频的MIDI片段。然后,他们进行了一项倾听研究,对来自Amazon Mechanical Turk的志愿者进行了任务评估,对四个类别中的50个片段进行了评分:

正确性:生成的歌曲与视频内容之间的相关性如何。

噪音:哪首歌的噪音最小。

同步:哪首歌曲在时间上与视频内容最一致。

总体:他们更喜欢听哪首歌。

研究人员报告说,评估人员发现,与其他基准系统相比,Foley Music的音乐很难与真实录音区分开。而且,MIDI事件表示似乎有助于改善声音质量,语义对齐和时间同步。

“结果表明,通过身体关键点和MIDI表示可以很好地建立视觉和音乐信号之间的相关性。我们还证明了我们的框架可以轻松扩展,以通过MIDI表示生成不同风格的音乐,”合著者写道。“我们认为我们的工作将为使用中间主体关键点

2016-2022 All Rights Reserved.平安财经网.复制必究 联系QQ 备案号:

本站除标明“本站原创”外所有信息均转载自互联网 版权归原作者所有。

邮箱:toplearningteam#gmail.com (请将#换成@)